サンフランシスコ大学の研究者は、単語を使用せずに患者がデバイスを介して「話す」ことができる神経インターフェースを開発しました。

これは、神経プロテーゼの分野における画期的な出来事です。システムは、脳の活動を監視し、人工の音声(いわばGoogleやAmazonの音声アシスタントなど)を使用してそれを単語に変換します。 ソフトウェアは非常に高度で、喉頭、舌、唇、顎の正確な仮想再構成が含まれています。

なぜ私たちは言葉を失うのですか?

患者は、変性疾患、事故、または脳の損傷など、さまざまな理由で話す能力を失います。 すでに使用されているテクノロジーでは、小さな顔の動きを「変換」したり、コミュニケーションを非常に長く面倒にする他のメカニズムを使用したりして、いくつかの単語を発音できます。

サンフランシスコで研究されている神経インターフェースは、言語の中心が声道の動きを調整する方法を「模倣する」インフラストラクチャを使用して、脳の活動を自然に聞こえる言語に直接翻訳します。

「声道の動きと言葉の音の関係は本当に複雑です」 サイコロ ゴパラアヌマンチパリ、プロジェクトに関与した研究者の一人。 「これらの言語センターが動きをコード化し、何らかの方法で翻訳すれば、脳の信号から始めてこの操作を行うこともできると考えました」.

それは何で構成されていますか?

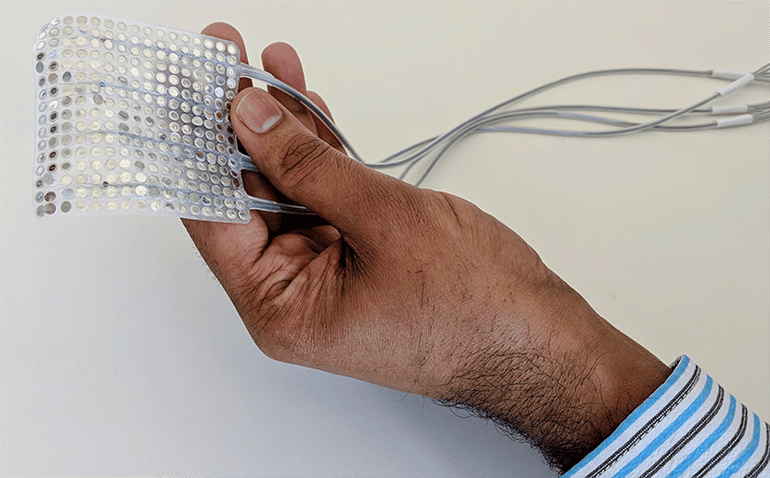

これが、チームが機械学習を使用して徐々に正確なサウンドを徐々に生成する「仮想」声道を作成した理由です。 ボランティアのグループは、脳の活動を監視しながら特定のフレーズを発声します。採用された人工知能がこれらの信号をスキャンし、声道の動きと比較して、特定の音にどのように変換されるかを正確に理解します。

「私たちは話し言葉を完全に模倣する能力を持っています」 サイコロ ジョシュチャーター、別の研究者。 「 'sh'や 'z'のような遅い、または柔らかいサウンドはすでに非常に進んでいますが、 'b'や 'p'のような切り捨てられたサウンドでは苦労しています。 ただし、機械学習を使用しているため、精度のレベルは驚くほど速くなります。」

「腕と脚を動かすことができない人々は、脳でロボット補綴物を制御することを学んだ」 シャルティエは続けます。 「いつの日か、音声障害のある人がこの音声補綴物を使って話すことを学ぶようになると確信しています。」

Natureで公開