カリフォルニア大学サンディエゴ校の研究者は最近、鳥が何を歌おうとしているのかを予測する機械学習システムを構築しました。

実用的な可能性があまりない場合は、まず、音声補綴物のリアルタイム予測音声合成はすでに素晴らしいことだとお話しします。 しかし、鳥のさえずりを理解することの意味は、はるかに進む可能性があります。

鳥のさえずり、非常に明瞭な世界

鳥のさえずりは、リズム、音色、そして最も重要なこととして、習得した行動を含む複雑な形のコミュニケーションです。

研究者によると、鳥の鳴き声を理解する(そして予測するのに十分なものを構築できる)ようにAIを教えることは、人間の生物学的発声に取って代わるための貴重な一歩です。

モータープロテーゼは、動物モデルとして霊長類を使用しました。 音声補綴物の同様のモデルはありません。 これがおそらく、これらがニューラルインターフェイステクノロジー、ブレインカバレッジ、および行動研究デザインの点でより制限されている理由です。

鳥の鳴き声について「考える」のは簡単ではありませんが、それは重要なステップです

鳴き鳥は、学習した複雑な発声行動の興味深いモデルです。 鳥のさえずりは、人間の言語と多くのユニークな類似点を共有しています。 それを研究することは、発声運動技能の学習、実行、維持の根底にあるメカニズムと回路に関する優れた一般的な情報をすでに提供しています。

しかし、発声をリアルタイムで翻訳することは簡単なことではありません。 現在のシステムは、私たちの自然な思考-スピーチパターンと比較してまだ遅いです。

かっこいいので、考えてみてください。最先端の自然言語処理システムは、人間の思考に追いつくのにまだ苦労しています。

私たちはまだ車には速すぎます

GoogleアシスタントやAlexaを操作するとき、実際の人と話すことから予想されるよりも長い休止がしばしばあります。 これは、人工知能が私たちのスピーチを処理し、その能力に関連して各単語の意味を決定し、次にどの反応またはプログラムにアクセスして応答するかを発見しているためです。

もちろん、これらのクラウドベースのシステムがこの速度で実行されることはすでに驚くべきことです。 しかし、それでも、無声者が思考の速度で話すことを可能にするリアルタイムのインターフェースを作成するには十分ではありません。

鳥のさえずりに関する研究

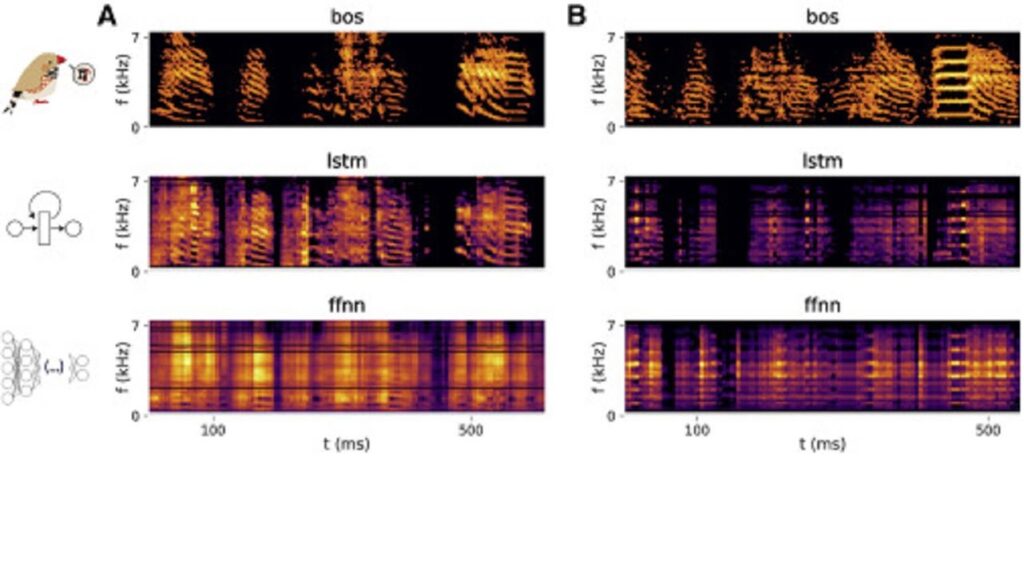

最初に、チームはXNUMXダースの鳥の脳(キンカチョウ)に電極を埋め込み、鳥の鳴き声の間に脳の活動を記録し始めました。

しかし、歌の間に鳥の神経活動を認識するために人工知能を訓練するだけでは十分ではありません。鳥の脳でさえ、ニューロン間のコミュニケーションの機能を完全にマッピングするには複雑すぎます。

このために、研究者は、人工知能が機能できる認識可能なパターンにリアルタイムで曲を減らすための別のシステムを訓練しました。

それは未解決の問題の解決策を提供するので、それは非常に興味深いものです。

リアルタイムの鳥の鳴き声の処理が印象的です そして、これらの結果を人間の言語で複製することは歴史的です。

しかし、この最初の仕事はまだ準備ができていません。 そして、それはまだ他の音声システムに適応できません。 鳥のさえずりを超えては機能しないかもしれません。

しかし、もしそうなら、それは2014年の深層学習の復活以来、ブレインコンピューターインターフェースの最初の巨大な技術的飛躍のXNUMXつになるでしょう。