スタンフォード大学の研究者は、 ブレイン・コンピューター・インターフェース(BCI). 毎分最大 62 語の速度で話し言葉を解読できる技術を開発することで、チームは以前の記録を 3 倍近く改善しました。

これらのシステムを自然な会話のリズムに少し近づけ、実質的に瞬時の音声変換を可能にする開発です。

言葉言葉言葉

イーロン・マスクと共にNeuralinkの共同創設者、 マックスホダックはスタンフォード大学の研究を「ブレインコンピューターインプラントの有用性における大きな変化」と呼んだ。しかし、それは正確には何で構成されているのでしょうか?

すべての作業の核心は、 ここにリンクしている論文で詳しく説明されています、機械学習アルゴリズムを使用して、脳信号を一貫した音声に「変換」する能力です。そして、皮質の比較的狭い領域における脳活動を分析することによってそれを行います。

ターゲット? ALSなどの病気で話すことができなくなった人の声を取り戻すお手伝いをします。品質の真の飛躍: このタイプの音声インターフェースは、脳信号の解読を大幅に加速する可能性があります。

テスト

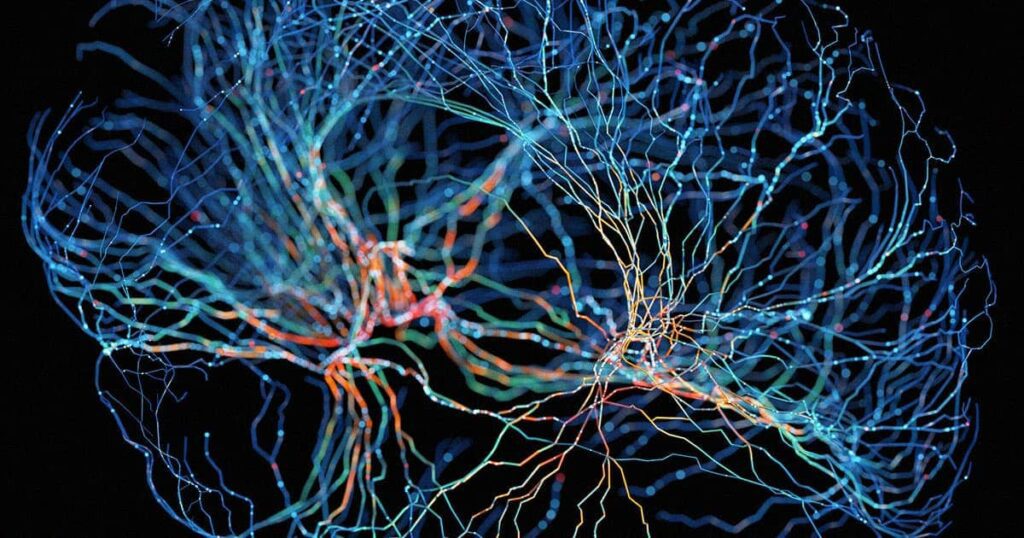

ある実験では、研究チームは、口を動かすことはできるが、言葉を作ることが困難なALS患者の神経活動を(脳の2つの小さな領域から)記録した。

テキストを予測できる再帰型ニューラル ネットワーク デコーダーを使用して、研究者はこれらの手がかりを単語に変換しました。 かつてない速さで進む言葉。

顔の動きとそれに関連する神経活動の分析は、麻痺や大脳皮質の拡張が限られているにもかかわらず、脳とコンピューターのインターフェースシステムをサポートするのに十分強力であることが発見されました。

直面する課題

現在、システムは高速ですが、まだ不完全です: 研究者が使用する再帰型ニューラル ネットワーク (RNN) デコーダーのエラー率 まだ20%です。

研究者らはこのことをよく知っている。「私たちの実証は、たとえそれがまだ完全で臨床的に実行可能なシステムではないとしても、皮質内記録から試みられた発話動作の解読が有望なアプローチであることの証拠である」と彼らは書いている。

誤り率を改善し、アルゴリズムを最適化するために、研究は今後、脳のより多くの領域を調査することを目的としています。

そのようなテクノロジーと人工知能を組み合わせたものを想像してみてください。 などの声を完全に複製できるアルゴリズム マイクロソフトが最近発表したもの わずか 3 秒の音声です。

将来、誰も黙っていることはありません。